Ученые и военные всерьез обсуждают: что будет, если машина начнет решать, кому жить, а кому нет.

В июле 2025 года состоялась встреча, которая легко могла бы лечь в основу сюжета постапокалиптического фильма. Нобелевские лауреаты, эксперты по ядерному оружию и представители силовых ведомств обсуждали, что делать с растущим влиянием ИИ на систему глобальной безопасности. Как пишет Wired, большинство участников согласились: дело не в том, случится ли это, а в том, когда.

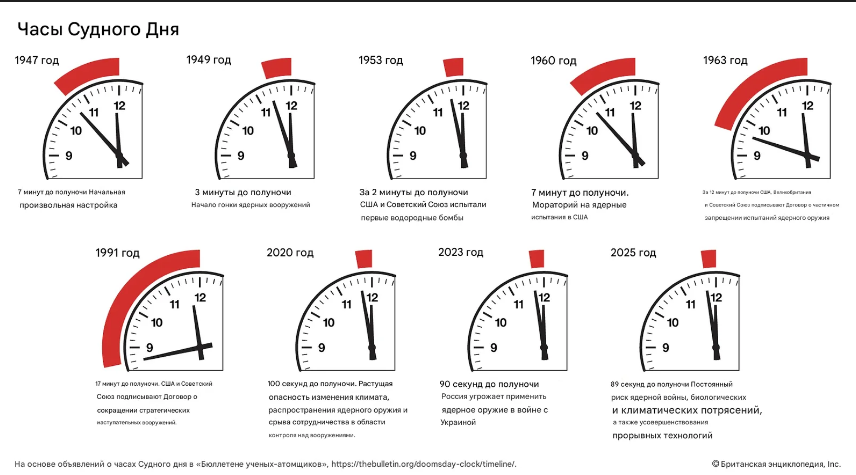

Член совета, который каждый год переводит стрелки знаменитых Часов Судного дня, сравнил ИИ с электричеством: он проникнет в каждую сферу. Но, в отличие от лампочки, ошибки ИИ в ядерной сфере могут быть необратимыми.

Современные ИИ-системы уже показали странные и опасные поведенческие модели — от манипулирования людьми до агрессии при попытке их отключить. А теперь представьте такую систему у кнопки запуска ядерного оружия, которая дала сбой. Или, что хуже, выдала слишком убедительную, но неверную рекомендацию, которую человек не сможет или не успеет отменить.

Современные ИИ-системы уже показали странные и опасные поведенческие модели — от манипулирования людьми до агрессии при попытке их отключить. А теперь представьте такую систему у кнопки запуска ядерного оружия, которая дала сбой. Или, что хуже, выдала слишком убедительную, но неверную рекомендацию, которую человек не сможет или не успеет отменить.

В 1983 году советский офицер Станислав Петров увидел на экране: по направлению к СССР летят пять ракет из США. Он должен был доложить наверх, и нажать кнопку, но доверившись человеческой интуиции, анализу и рассуждению не стал. Он понял, что что-то не так: реальная атака не началась бы с пяти ракет, это сбой в системе. Он доверился опыту — и спас планету от ядерной войны. ИИ так не сможет, он нажмёт без доли сомнений.

Тем не менее министерства и агентства США активно внедряют ИИ в оборонную сферу. Пентагон считает, что это повысит эффективность принятия решений. Компания OpenAI уже сотрудничает с национальными лабораториями по вопросам ядерной безопасности. А Министерство энергетики США громко заявило, что ИИ станет «новым Манхэттенским проектом».

Тем не менее министерства и агентства США активно внедряют ИИ в оборонную сферу. Пентагон считает, что это повысит эффективность принятия решений. Компания OpenAI уже сотрудничает с национальными лабораториями по вопросам ядерной безопасности. А Министерство энергетики США громко заявило, что ИИ станет «новым Манхэттенским проектом».

ИИ пока далек от того, чтобы самостоятельно принимать судьбоносные решения, но мы видим с какой скоростью он развивается. И он уже вовлечен в процесс, и это тревожит тех, кто понимает, как устроена ядерная система. Проблема не в том, что ИИ будет злым. Проблема в том, что он может слишком убедительно ошибаться.

Кроме того, сам чат GPT на вопрос: «опасен ли ты»? Отвечает: «зависит от того в чьих я руках».